本帖最后由 pig2 于 2014-8-20 18:20 编辑

问题导读:

1.你对flume了解多少

2.flume配置文件有什么作用?

3.通过什么方法可以封装flume启动脚本?

在已经成功安装Flume的基础上,本文将总结使用Flume进行数据的实时收集处理,具体步骤如下:

第一步,在$FLUME_HOME/conf目录下,编写Flume的配置文件,命名为flume_first_conf,具体内容如下:

- #agent1表示代理名称

- agent1.sources=source1

- agent1.sinks=sink1

- agent1.channels=channel1

-

- #Spooling Directory是监控指定文件夹中新文件的变化,一旦新文件出现,就解析该文件内容,然后写入到channle。写入完成后,标记该文件已完成或者删除该文件。

- #配置source1

- agent1.sources.source1.type=spooldir

- agent1.sources.source1.spoolDir=/home/yujianxin/hmbbs

- agent1.sources.source1.channels=channel1

- agent1.sources.source1.fileHeader = false

- agent1.sources.source1.interceptors = i1

- agent1.sources.source1.interceptors.i1.type = timestamp

-

- #配置channel1

- agent1.channels.channel1.type=file

- agent1.channels.channel1.checkpointDir=/home/yujianxin/hmbbs/hmbbs_tmp123

- agent1.channels.channel1.dataDirs=/home/yujianxin/hmbbs/hmbbs_tmp

-

- #配置sink1

- agent1.sinks.sink1.type=hdfs

- agent1.sinks.sink1.hdfs.path=hdfs://slave3:9000/hmbbs

- agent1.sinks.sink1.hdfs.fileType=DataStream

- agent1.sinks.sink1.hdfs.writeFormat=TEXT

- agent1.sinks.sink1.hdfs.rollInterval=1

- agent1.sinks.sink1.channel=channel1

- agent1.sinks.sink1.hdfs.filePrefix=%Y-%m-%d

第二步,编写Shell脚本,执行Flume任务

- vi flume1.sh

-

- #!/bin/sh

- flume-ng agent -n agent1 -c conf-f /home/yujianxin/flume/apache-flume-1.4.0-bin/conf/flume_first_conf

- -Dflume.root.logger=DEBUG,console >./flume1.log 2>&1 &

- 让日志收集任务以后台进程运行,且将运行日志重定向到./flume1.log保存。

验证

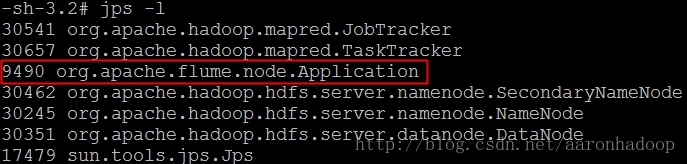

通过命令行查看新启的进程

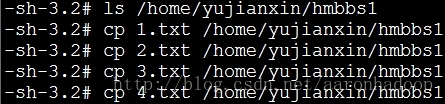

不断往Flume监控的目录/home/yujianxin/hmbbs1下放置文件

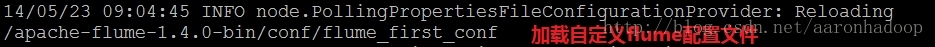

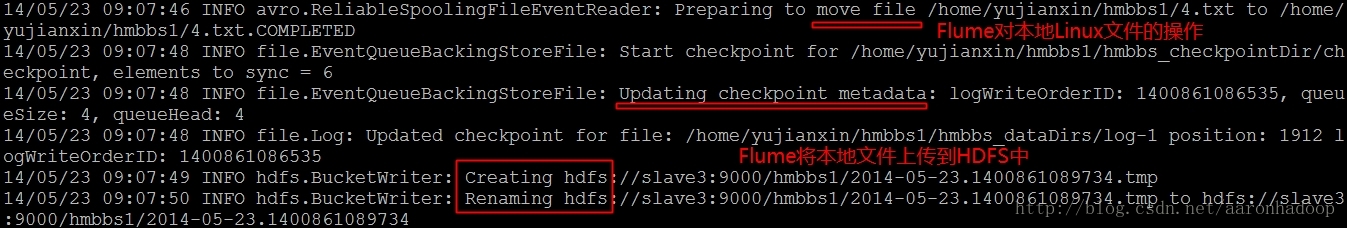

查看./flume.log运行日志,截部分关键图如下

查看成功上传到HDFS中的文件

OK!使用Flume自动监控指定目录下文件的变化,自动处理,上传到HDFS。比以前自己写Shell脚本方便、快捷、高效多了,哈哈

|  /2

/2