sparkstreaming 读取kafka日志数据,窗口处理为1分钟,日志数据自带时间戳,想根据日志时间戳进行分钟级别的数据统计,这个怎么支持实现?structed streaming 支持event Time,但是怎么让sparkstreaming 实现这种统计呢?

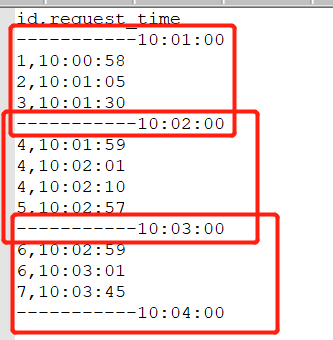

比如日志数据如下:

日志数据为id+request_time

想要根据kafka日志数据里面的request_time进行统计,但是日志数据传到sparkstreaming后的process_time肯定大于日志数据里面的时间,sparkstreaming接收过来的1分钟的窗口数据里面的日志数据跨分钟级别了

日志数据为id+request_time,想统计每分钟的访问人数,sparkstreaming窗口为1分钟

|  /2

/2