问题导读

1.部署Spark1.4.1下SparkR包含哪些步骤?

2.如何运行运行sparkR?

[Author]: kwu (和讯大数据)

基本CDH5.4的Spark1.4.1下SparkR的部署,R与Spark的结合为数据分析提供高效的解决方案,Hadoop的中hdfs为数据分析提供分布式存储。本文介绍集成安装的步骤:

1、集群的环境

CDH5.4+Spark1.4.1

配置环境变量

[mw_shl_code=bash,true]#java

export JAVA_HOME=/usr/java/jdk1.7.0_67-cloudera

export JAVA_BIN=$JAVA_HOME/bin

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_HOME/bin

export JAVA_LIBRARY_PATH=/opt/cloudera/parcels/CDH/lib/hadoop/lib/native

export MAVEN_HOME=/opt/softwares/apache-maven-3.3.3

export PATH=$PATH:$MAVEN_HOME/bin

#rhadoop

export HADOOP_HOME=/opt/cloudera/parcels/CDH/lib/hadoop

export HADOOP_CONF_DIR=/etc/hadoop/conf

export HADOOP_CMD=/usr/bin/hadoop

export HADOOP_STREAMING=/opt/cloudera/parcels/CDH/lib/hadoop-0.20-mapreduce/contrib/streaming/hadoop-streaming-2.6.0-mr1-cdh5.4.0.jar

export HIVE_HOME=/opt/cloudera/parcels/CDH/lib/hive

export R_HOME=/usr/lib64/R

#spark

export SPARK_HOME=/opt/modules/spark

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

export LANG=zh_CN.UTF-8[/mw_shl_code]

2、R语言环境最新版本R-3.2.2

1) 安装R前需要打的补丁

[mw_shl_code=bash,true]yum -y install gcc-gfortran

yum -y install gcc gcc-c++

yum -y install readline-devel

yum -y install libXt-devel[/mw_shl_code]

2) 下载R安装需要的软件包,注意这里不要使用yum安装,否则造成java版本不一致的情况。

需要下载的包:

R-3.2.2.tar.gz

rJava_0.9-7.tar.gz

rhdfs_1.0.8.tar.gz

下载链接: http://pan.baidu.com/s/1nt5qkJn

3) 安装R-3.2.3

解压安装包

[mw_shl_code=bash,true]tar zxfv R-3.2.2.tar.gz[/mw_shl_code]

编译安装

[mw_shl_code=bash,true]./configure[/mw_shl_code]

[mw_shl_code=bash,true]make && make install[/mw_shl_code]

4) 安装rJava与rhdfs

R CMD INSTALL "rJava_0.9-7.tar.gz"

R CMD INSTALL "rhdfs_1.0.8.tar.gz"

5)设置native

export JAVA_LIBRARY_PATH=/opt/cloudera/parcels/CDH/lib/hadoop/lib/native

native下面的libhadoop.so.0 及 libhadoop.so.1.0.0拷贝到 /usr/lib64

6)注意以上步骤,需要集群中所有的节点都要安装。

3、运行sparkR

最新版本的Spark1.4.1在编译时,就集成了sparkR的组件:

启动sparkR

[mw_shl_code=bash,true]/opt/modules/spark/bin/sparkR --master spark://10.130.2.20:7077 --executor-memory 8g --total-executor-cores 45 --conf spark.ui.port=54089[/mw_shl_code]

启动时分配相应的内存、CPU资源及UI的端口

1)启动日志:

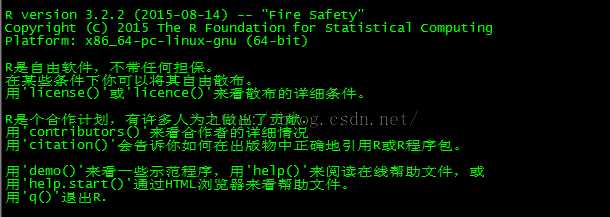

开始显示R的版本,这与原来的R启动显示一致

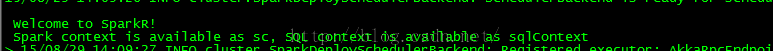

启动完毕出现 Welcome to SparkR 则为成功运行sparkR

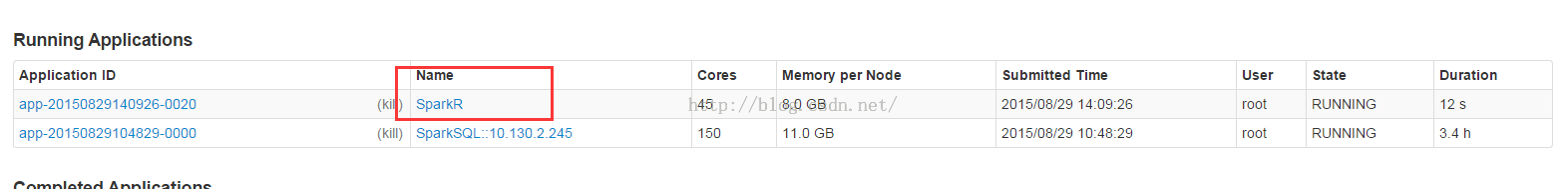

2) 在spark集群监控页面查看:

SparkR与集群中的任务一样,出现在Running Applications的列表中

ok , 基于CDH5.4的Spark1.4.1下SparkR的部署完毕,以上提到命令及安装包本人亲测试并运行成功。转载请注明和讯大数据,谢谢。

|

/2

/2