| 尴尬了, |

| 不错,挺好的 |

| 正好需要这块东西,谢谢楼主! |

撑伞的鱼 发表于 2015-7-1 14:12 尝试修改spark-default.conf 具体如下 spark.driver.extraJavaOption -Dhdp.version=current spark.yarn.am.extraJavaOption -Dhdp.version=current 然后启动spark shell bin/spark-shell --master yarn-cluent |

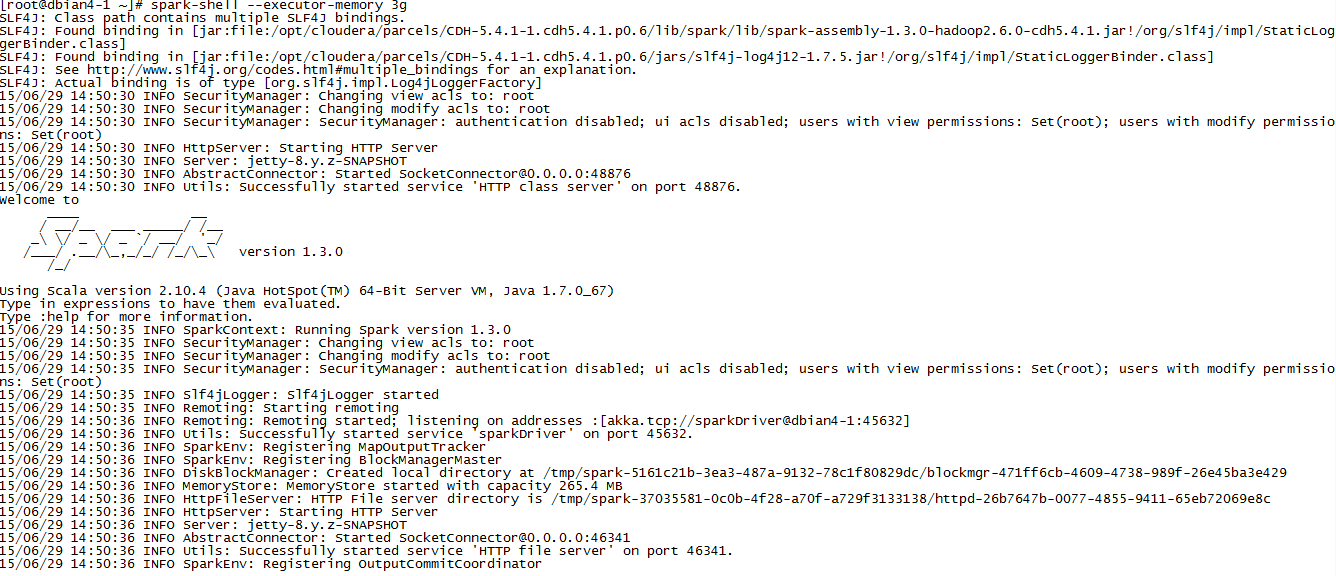

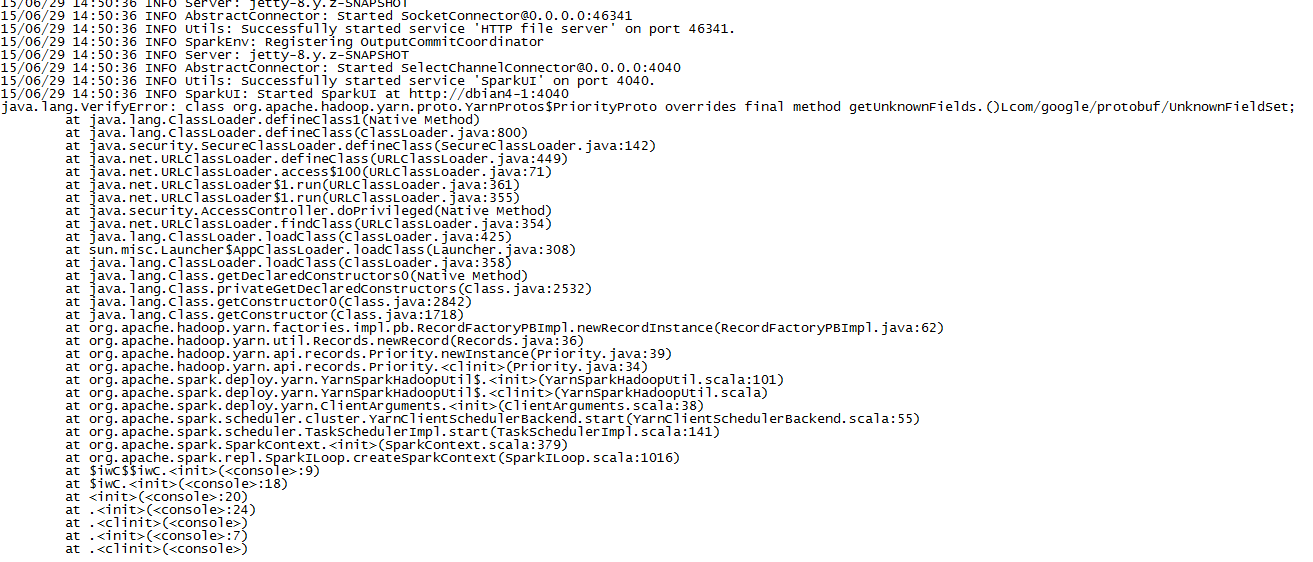

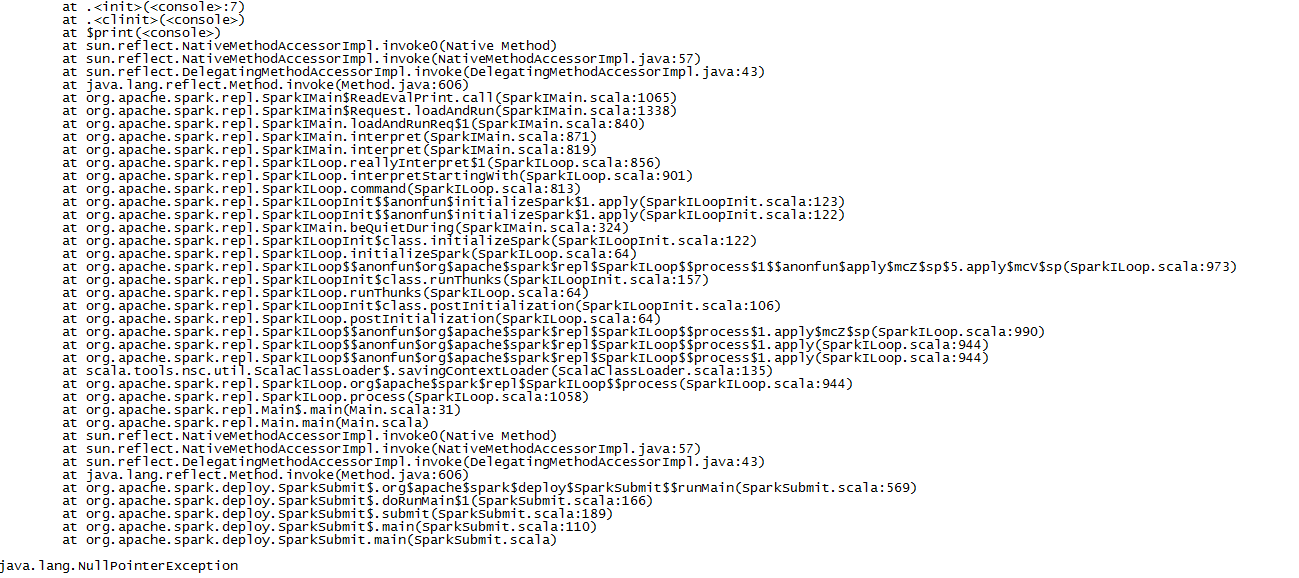

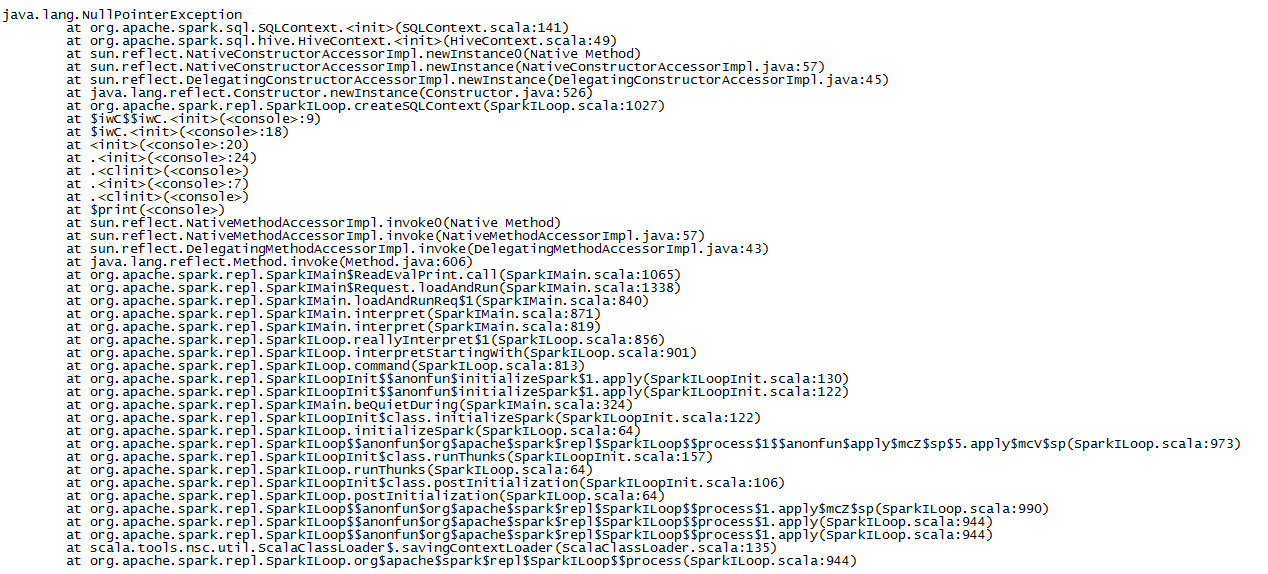

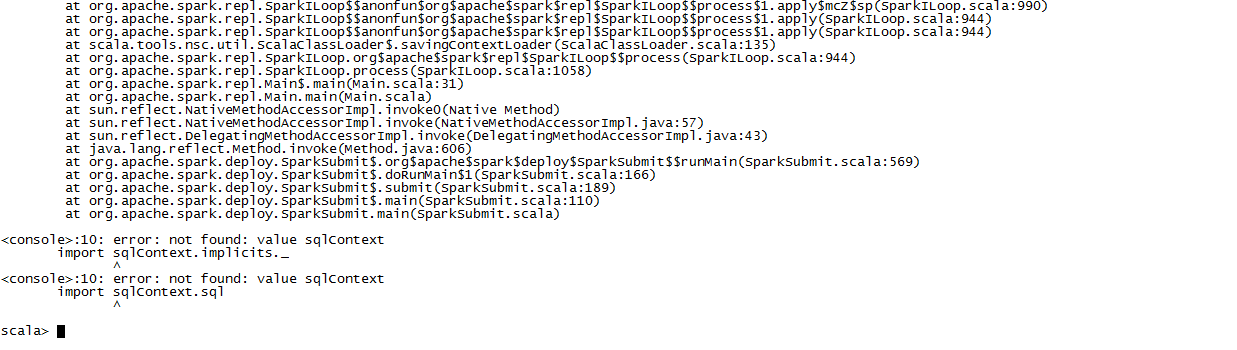

| 您好,我现在按照您帖子中的步骤执行下来,在启动spark-shell时出错了,无法往下执行了,网上也没有找到具体解决这个错误的方法,只好向您请教了,还望您能指导一下,非常感谢!附件中是我错误的截图信息,望您能不吝赐教。 |

| 这个很赞,收藏了。 |

/2

/2