|

本帖最后由 pig2 于 2017-6-26 15:57 编辑 启动集群小记录: 以前执行start-master.sh和 都是没有问题的。 后来执行[mw_shl_code=bash,true]start-slaves.sh [/mw_shl_code] 出现下面问题 [codeUsage: ./sbin/start-slave.sh [options] <master> Master must be a URL of the form spark://hostname:port Options: -c CORES, --cores CORES Number of cores to use -m MEM, --memory MEM Amount of memory to use (e.g. 1000M, 2G) -d DIR, --work-dir DIR Directory to run apps in (default: SPARK_HOME/work) -i HOST, --ip IP Hostname to listen on (deprecated, please use --host or -h) -h HOST, --host HOST Hostname to listen on -p PORT, --port PORT Port to listen on (default: random) --webui-port PORT Port for web UI (default: 8081) --properties-file FILE Path to a custom Spark properties file. Default is conf/spark-defaults.conf.[/code] 以为是环境变量出现问题。 解决办法: 1.原来是因为有的机器worker进程没有关闭掉导致的。2.可以使用start-slave.sh spark://Master:7077 |

|

本帖最后由 pig2 于 2017-3-31 18:09 编辑 sbin目录下的脚本文件: [codeslaves.sh 在所有定义在${SPARK_CONF_DIR}/slaves的机器上执行一个shell命令 spark-config.sh 被其他所有的spark脚本所包含,里面有一些spark的目录结构信息 spark-daemon.sh 将一条spark命令变成一个守护进程 spark-daemons.sh 在所有定义在${SPARK_CONF_DIR}/slaves的机器上执行一个spark命令 spark-executor 运行org.apache.spark.executor.MesosExecutorBackend,具体作用暂时没关注 start-all.sh 启动master进程,以及所有定义在${SPARK_CONF_DIR}/slaves的机器上启动Worker进程 start-history-server.sh 启动历史记录进程 start-master.sh 启动spark master进程 start-slave.sh 启动某机器上spark slave进程 start-slaves.sh 在所有定义在${SPARK_CONF_DIR}/slaves的机器上启动Worker进程 stop-all.sh 在所有定义在${SPARK_CONF_DIR}/slaves的机器上停止Worker进程 stop-history-server.sh 停止历史记录进程 stop-master.sh 停止spark master进程 stop-slaves.sh 停止某机器上spark slave进程[/code] |

|

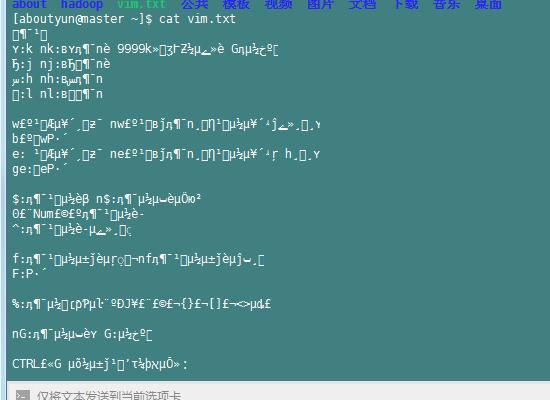

hadoop集群验证: hadoop集群验证方式很多种,这里直接上传一个windows7文件。下面内容,保存未vim.txt文件 移动光标 保存后,复制到Linux,然后通过命令

乱码,

主要是window下是gbk,Linux下是utf8.所以需要转换下

转换后,上传即可看到

同时证明集群安装配置成功 |

|

本帖最后由 pig2 于 2017-1-25 20:09 编辑 远程复制纠正: 下面方式严格来讲,不正确的

需去掉-r

并且特别注意远程复制之后需要生效环境变量。

涉及到hadoop集群及spark集群的配置 |

本帖最后由 pig2 于 2017-1-18 19:08 编辑 pig2 发表于 2017-1-10 17:32 远程复制: 在/data目录的软件。配置完毕,远程复制,如果没有授权的情况下,只能复制到/home/aboutyun目录下。 对/data授权

即可实现远程复制,如复制hadoop

如果无授权,则出现下面情况

|

本帖最后由 pig2 于 2017-1-11 16:21 编辑

解压后注意更改权限 同样hadoop,spark也是

|

|

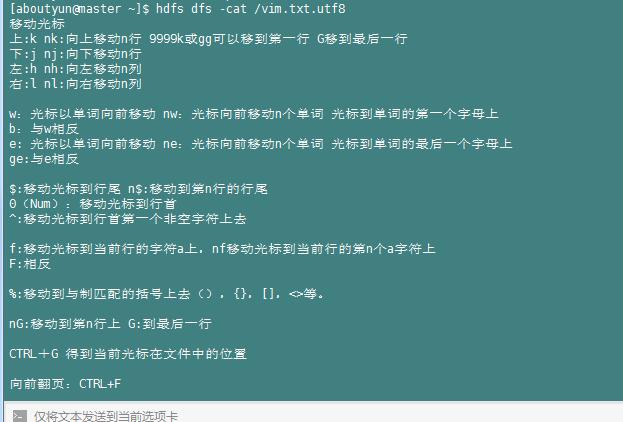

上述安装软件包下载地址 链接:http://pan.baidu.com/s/1eRJctZ8 密码:u8jh

|

|

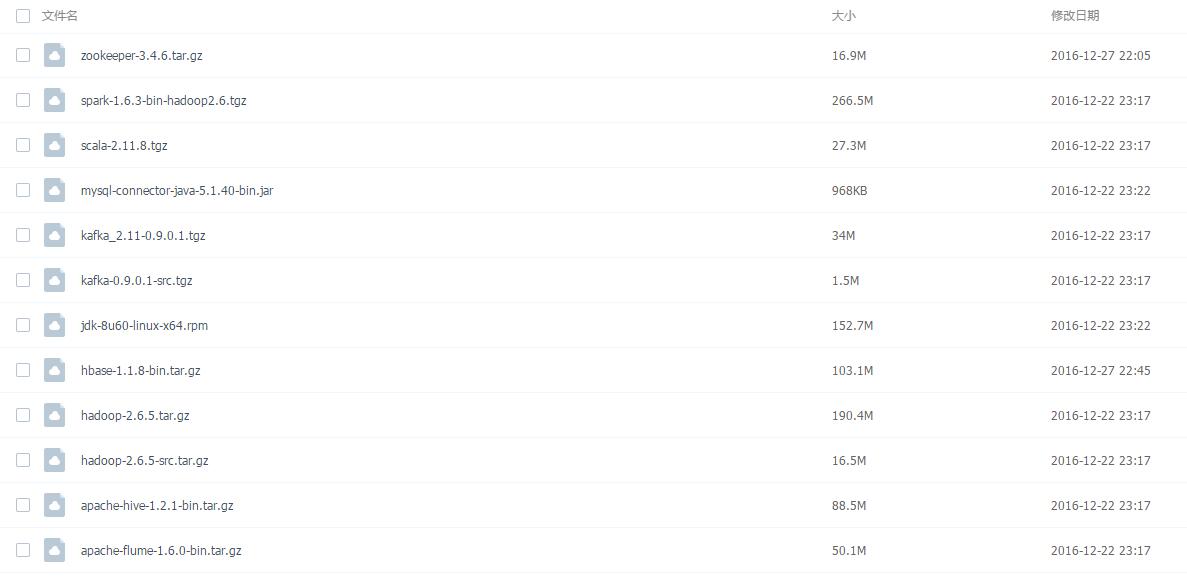

ntp设置补充,master同步网络服务器,slave1和slave2可同步master的时间 ntp设置中:master同步网络服务器 server 0.centos.pool.ntp.org iburst server 1.centos.pool.ntp.org iburst server 2.centos.pool.ntp.org iburst server 3.centos.pool.ntp.org iburst slave1和slave2同步master的时间 注释上面信息采用,在配置文件中/etc/ntp.conf中注释上面信息 直接添加

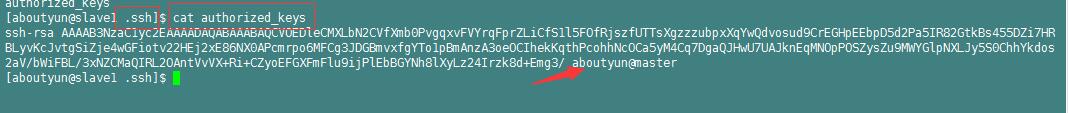

ssh-copy-id -i ~/.ssh/id_rsa.pub aboutyun@slave1 的含义是: 将master的公钥远程复制到slave1的authorized_keys文件中:

|

/2

/2