|

是不是类冲突 |

| scala 2.12.x的版本应该移除试试! |

|

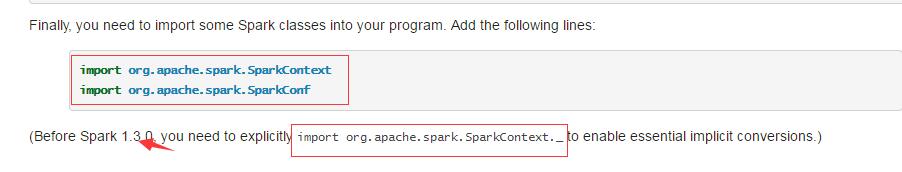

本帖最后由 easthome001 于 2017-3-16 14:42 编辑 spark1.3以前是这么做,你的这个是spark1.6的尝试下面的 [mw_shl_code=bash,true]import org.apache.spark.SparkContext import org.apache.spark.SparkConf[/mw_shl_code]

|

|

Hadoop-env.sh 添入export hadoop classpath=? |

海滩发红 发表于 2017-3-16 14:00 环境变量 |

langke93 发表于 2017-3-16 13:40 export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath) 是这条语句吗? |

海滩发红 发表于 2017-3-16 13:37 hadoop classpath配置了吗 |

langke93 发表于 2017-3-16 13:36 是官网上下的 |

/2

/2