日志

csv导入HBase

0 前置

example.csv文件

echo '999999941017403,1471848231000,120.6817399807754,27.95172926917687,0,0' >example.csv

问题

用hadoop jar /opt/apps/hbase-1.1.1/lib/hbase-server-1.1.1.jar importtsv -Dimporttsv.separator=, -Dimporttsv.columns="HBASE_ROW_KEY,cf1:f1,cf1:c2,cf2:c1" test /example.csv命令从csv文件导数据到HBase中时,会将数字(long/double)当做字符串转化成字节数组存储到HBase,这样导致java程序读long/double会解析异常(Bytes.toDouble(cell.getValue()))。

尝试了Phoenix,过程中也会出现一些问题,比如phoenix会自动写一个_0的列到HBase中,而且使用hadoop jar /opt/apps/phoenix-4.7.0-HBase-1.1-bin/phoenix-4.7.0-HBase-1.1-client.jar org.apache.phoenix.mapreduce.CsvBulkLoadTool时默认表名都是大写,目前还没找到解决方案。

下面使用了Hive来导数据,经过测试是可行的。

1.创建Hive表

CREATE TABLE example(key bigint, c1 bigint,c2 double,c3 double,c4 bigint,c5 bigint) STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler'

WITH SERDEPROPERTIES ("hbase.columns.mapping" = ":key#b,cf1:c1#b,cf1:c2#b,cf1:c3#b,cf1:c4#b,cf1:c5#b")

TBLPROPERTIES ("hbase.table.name" = "example", "hbase.mapred.output.outputtable" = "example");

备注:

hbase.columns.mapping中的#b表示以binary形式写入HBase,对于非string类型的如int/long/double等类型字段需要使用#b

2.创建数据中转的Hive表

由于hive的load data指令不能针对上述创建的HBase映射Hive表(example),所以需要先load进一个临时表,然后从临时表insert进example表。

CREATE TABLE example_shadow(key bigint, c1 bigint,c2 double,c3 double,c4 bigint,c5 bigint) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' LINES TERMINATED BY '\n' STORED as textfile

备注:

a) 字段和example保持一致

b) 分隔符根据csv文件来定

3.load data

>load data local inpath '/pathtocsv' into table example_shadow;

4. insert to example

>add jar /opt/apps/phoenix-4.7.0-HBase-1.1-bin/phoenix-4.7.0-HBase-1.1-server.jar;

>insert overwrite table example select * from example_shadow;

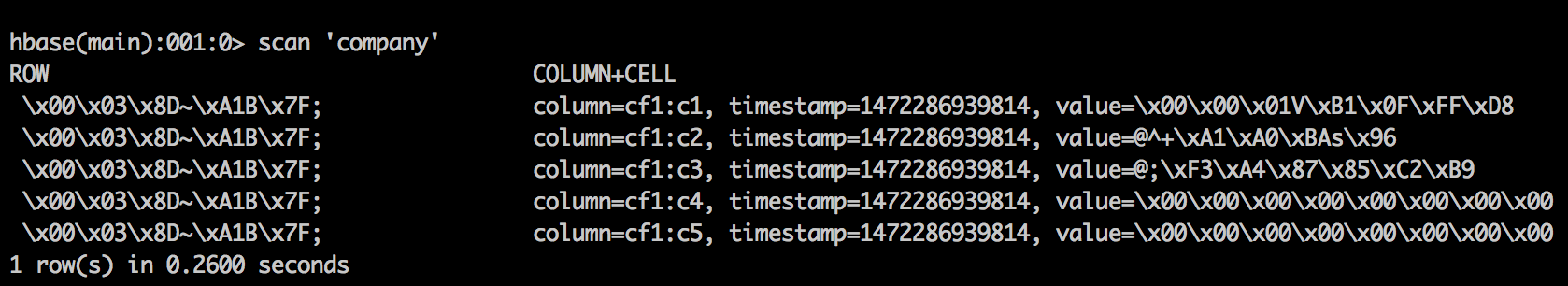

5.验证数据

>hbase shell

> scan 'example'

通过java代码读HBase相关字段的数据,比如double类型的,使用Bytes.toDouble(cell.getValue()),打印看是否正常。

https://yq.aliyun.com/articles/59457

/2

/2