本帖最后由 Oner 于 2017-9-23 16:52 编辑

问题导读:

1. 如何搭建一个zookeeper集群?

2. 安装zookeeper集群中myid文件的作用是什么?

3. 如何搭建一个kafka集群?

接上篇:about云日志分析项目准备7:Hive安装和配置

这篇主要讲解kafka集群的安装,由于kafka一部分依赖于zookeeper,所以在安装kafka之前需要先安装zookeeper。

一、安装zookeeper

在master机器进行以下操作。

1. 解压zookeeper

下载zookeeper:http://apache.fayea.com/zookeeper/zookeeper-3.4.6/zookeeper-3.4.6.tar.gz

- tar -zxvf ~/jar/zookeeper-3.4.6.tar.gz -C /data

链接: https://pan.baidu.com/s/1i50vzb3 密码: p5s5

2. 配置zookeeper

涉及到的配置文件为

- ${ZOOKEEPER_HOME}/conf/zoo.cfg

zoo.cfg通过cp zoo_sample.cfg zoo.cfg得到。

- # The number of milliseconds of each tick

- tickTime=2000

- # The number of ticks that the initial

- # synchronization phase can take

- initLimit=10

- # The number of ticks that can pass between

- # sending a request and getting an acknowledgement

- syncLimit=5

- # the directory where the snapshot is stored.

- # do not use /tmp for storage, /tmp here is just

- # example sakes.

- dataDir=/data/zk_data

- # the port at which the clients will connect

- clientPort=2181

- server.1=master:2888:3888

- server.2=slave1:2888:3888

- server.3=slave2:2888:3888

zookeeper配置文件详解

http://www.aboutyun.com/thread-13909-1-1.html

3. 填写myid

在zoo.cfg配置文件中的dataDir目录(在这儿是/data/data_zk)下创建myid文件,文件内容为zoo.cfg中master所对应的server.X。

- echo "1" > /data/zk_data/myid

4. 复制到其他节点- scp -r /data/zookeeper-3.4.6/ /data/zk_data aboutyun@slave1:/data

- scp -r /data/zookeeper-3.4.6/ /data/zk_data aboutyun@slave2:/data

- echo "2" > /data/zk_data/myid

在slave2上,

- echo "3" >/data/zk_data/myid

5. 添加到环境变量

在master、slave1、slave2上,分别将以下内容添加到~/.bashrc文件中

- export ZOOKEEPER_HOME=/data/zookeeper-3.4.6

- export PATH=$ZOOKEEPER_HOME/bin:$PATH

6. 启动验证

在master、slave、slave2上,分别执行zookeeper启动命令。

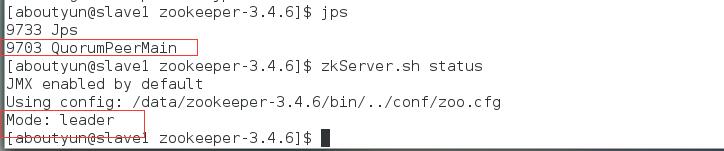

由于启动时,每个节点都会试图去连接其它节点,因此先启动的刚开始会连接不上其它的,导致日志中会包含错误信息,在未全启动之前,这个属正常现象。启动完成后,使用jps命令和zkServer.sh status命令经行验证

master机器情况:

slave1机器情况:

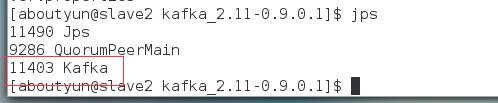

slave2机器情况:

说明每个节点都成功启动了QuorumPeerMain进程,并且slave1上的进程为leader,master和slave2上的进程为follower

二、安装kafka

在master上进行如下操作:

1. 解压kafka

下载kafka:http://apache.fayea.com/kafka/0.9.0.1/kafka_2.11-0.9.0.1.tgz

- tar -zxvf ~/jar/kafka_2.11-0.9.0.1.tgz -C /data

2. 配置kakfa

涉及到的配置文件为${KAFA_HOME}/config/server.properties

必须要配置的是这三个参数:broker.id、log.dirs、zookeeper.connect

broker.id表示当前broker的id,要求是唯一的非负数。log.dirs表示kafka日志的存放目录。zookeeper.connect表示连接的zookeeper的地址。

- broker.id=0

- log.dirs=/data/kafka-logs

- zookeeper.connect=master:2181,slave1:2181,slave2:2181

3. 复制到其他节点

- scp -r /data/kafka_2.11-0.9.0.1/ /data/kafka-logs/ aboutyun@slave1:/data

- scp -r /data/kafka_2.11-0.9.0.1/ /data/kafka-logs/ aboutyun@slave2:/data

4. 添加环境变量

在master、slave1、slave2机器上,分别将以下内容添加到~/.bashrc文件中

- export KAFKA_HOME=/data/kafka_2.11-0.9.0.1

- export PATH=$KAFKA_HOME/bin:$PATH

5. 启动验证

在master、slave1、slave2机器上,分别执行kafka启动命令

- cd $KAFKA_HOME

- kafka-server-start.sh -daemon ./config/server.properties

之后在每台机器上执行jps命令:

如果每台机器上都成功启动了kafka这个进程,说明我们搭建成功。如果发现某台机器上没有kafka这个进程,可以将kafka的启动命令去掉参数-daemon(加上的话表示后台启动),这样可以直接在屏幕上看到错误信息。

三、kakfa使用示例

1. 创建topic

- #创建一个有3个partition、1个副本的 test topic

- kafka-topics.sh --zookeeper master:2181,slave1:2181,slave2:2181 --create --topic test --replication-factor 1 --partitions 3

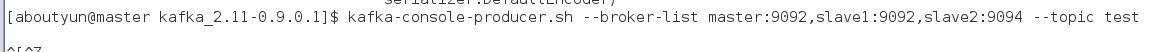

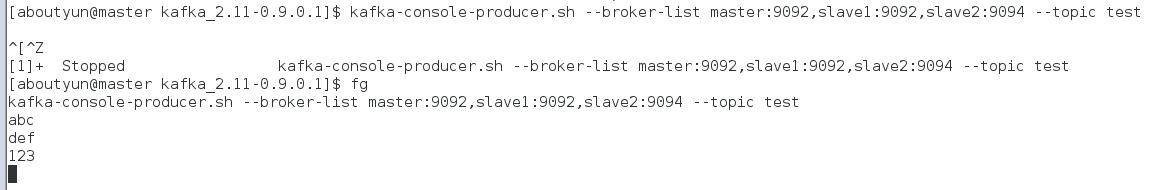

- kafka-console-producer.sh --broker-list master:9092,slave1:9092,slave2:9092 --topic test

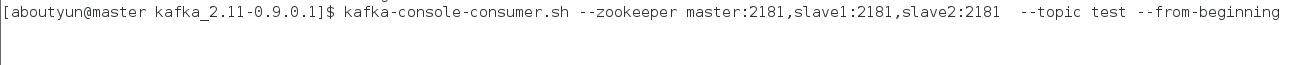

3. 创建consumer

重新打开一个窗口:

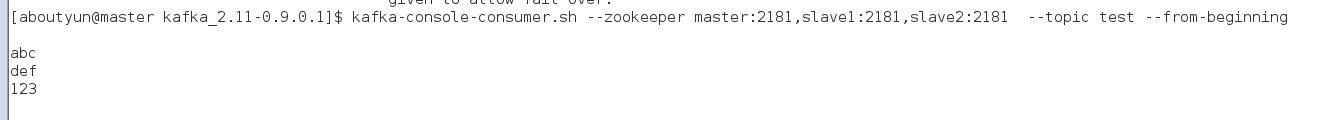

- kafka-console-consumer.sh --zookeeper master:2181,slave1:2181,slave2:2181 --topic test --from-beginning

4. 产生消息并接受

在producer的窗口中输入几条测试信息

查看consumer窗口的情况

说明成功消费了的产生的3条信息

四、踩过的坑

1. org.I0Itec.zkclient.exception.ZkException: Unable to connect to master:2181,slave1:2181,slave3:2181

第一次启动时没有看到kafka进程,后来去掉-daemon参数,发现报了这样的错误,起初以为是zookeeper没安装成功,所以提示无法连接zookeeper服务,后来仔细检查了下,发现报错信息提示只是无法连接的zookeeper服务中包括了slave3:2181,由于我们这儿只有master、slave1和slave2三台机器安装了zookeeper,并不包含slave3。

解决办法:将kafka的server.properties配置文件中zookeeper.connect值改为正确值,在这儿应该是 master:2181,slave1:2181,slave2:2181

|

/2

/2