本帖最后由 yuwenge 于 2018-4-2 18:21 编辑

上一篇

THU数据派

http://www.aboutyun.com/forum.php?mod=viewthread&tid=24237

20+案例教你可视化图表的设计方法

信息可视化包括了信息图形、知识、科学、数据等的可视化表现形式,以及视觉可视化设计方面的进步与发展。地图、表格、图形,甚至包括文本在内,都是信息的表现形式,无论它是动态的或是静态的,都可以让我们从中了解到我们想知道的内容,发现各式各样的关系,达到最终解决问题的目的。信息可视化的意义就是在于运用形象化方式把不易被理解的抽象信息直观地表现和传达出来。

我们用一个简单的例子来说明一下信息可视化:

上图所示是信任圈,一款基于Google+的信息可视化应用。Google+是一款类似于微博的社交软件,图中我们可以看到绿色为相互关注的人,黄色为你关注了他而对方没有关注你的人,红色为单方面关注你的人。这样一个信息图就可以清楚的反应出在Google+上,人与人之间的信任关系,这一抽象概念。

从上图看三位名人的信任圈就可以非常清楚明了的了解他们的交友状态这一更为抽象的概念。1为小甜甜布莱尼,2为英国著名音乐制作人,3为Facebook 马克。而图表呢?根据道格·纽瑟姆2004年定义,从表现形式的角度“信息图表”作为视觉工具应包括以下六类:图表、图解、图形、表格、地图、列表。

信息可视化图表则隶属于视觉传达的一种设计,是以凝练、直观和清晰的视觉语言,通过梳理数据构建图形、通过图形构建符号、通过符号构建信息,以视觉化的逻辑语言对信息进行剖析视觉传达方式。

一. 图表类型

信息可视化图表能使复杂问题简单化,能以直观方式传达抽象信息,使枯燥的数据转化为具有人性色彩的图表,从而抓住阅读群体的眼球。

设计的目的决定了图表设计的形式,按照形式特点我们常把图表分为关系流程图、叙事插图型、树型结构图、时间分布类及空间解构类五种类型。不管何种类型,都是运用列表、对照、图解、标注、连接等表述手段,使视觉语言最大化的融入信息之中,使信息的传达直观化、图像化、艺术化。

更多点击链接

GitHub最著名的20个Python机器学习项目!

我们分析了GitHub上的前20名Python机器学习项目,发现scikit-Learn,PyLearn2和NuPic是贡献最积极的项目。让我们一起在Github上探索这些流行的项目!

Scikit-learn:Scikit-learn 是基于Scipy为机器学习建造的的一个Python模块,他的特色就是多样化的分类,回归和聚类的算法包括支持向量机,逻辑回归,朴素贝叶斯分类器,随机森林,Gradient Boosting,聚类算法和DBSCAN。而且也设计出了Python numerical和scientific libraries Numpy and Scipy Pylearn2:Pylearn是一个让机器学习研究简单化的基于Theano的库程序。

MILK:MILK是Python语言下的机器学习工具包。它主要是在很多可得到的分类比如SVMS,K-NN,随机森林,决策树中使用监督分类法。 它还执行特征选择。 这些分类器在许多方面相结合,可以形成不同的例如无监督学习、密切关系金传播和由MILK支持的K-means聚类等分类系统。

REP:REP是以一种和谐、可再生的方式为指挥数据移动驱动所提供的一种环境。它有一个统一的分类器包装来提供各种各样的操作,例如TMVA, Sklearn, XGBoost, uBoost等等。并且它可以在一个群体以平行的方式训练分类器。同时它也提供了一个交互式的情节。

链接

零基础的我是这样开始写Python爬虫的(附代码)

刚开始接触爬虫的时候,简直惊为天人,十几行代码,就可以将无数网页的信息全部获取下来,自动选取网页元素,自动整理成结构化的文件。

利用这些数据,可以做很多领域的分析、市场调研,获得很多有价值的信息。这种技能不为我所用实在可惜,于是果断开始学习。

1. 并非开始都是最容易的

刚开始对爬虫不是很了解,又没有任何的计算机、编程基础,确实有点懵逼。从哪里开始,哪些是最开始应该学的,哪些应该等到有一定基础之后再学,也没个清晰的概念。

因为是 Python 爬虫嘛,Python 就是必备的咯,那先从 Python 开始吧。于是看了一些教程和书籍,了解基本的数据结构,然后是列表、字典、元组,各种函数和控制语句(条件语句、循环语句)。

学了一段时间,才发现自己还没接触到真正的爬虫呢,而且纯理论学习很快就忘了,回去复习又太浪费时间,简直不要太绝望。把 Python 的基础知识过了一遍之后,我竟然还没装一个可以敲代码的IDE,想想就哭笑不得。

2. 开始直接上手

转机出现在看过一篇爬虫的技术文章后,清晰的思路和通俗易懂的语言让我觉得,这才是我想学的爬虫。于是决定先配一个环境,试试看爬虫到底是怎么玩的。(当然你可以理解为这是浮躁,但确实每个小白都想去做直观、有反馈的事情)

因为怕出错,装了比较保险的 Anaconda,用自带的 Jupyter Notebook 作为IDE来写代码。看到很多人说因为配置环境出各种BUG,简直庆幸。很多时候打败你的,并不是事情本身,说的就是爬虫配置环境这事儿。

遇到的另一个问题是,Python 的爬虫可以用很多包或者框架来实现,应该选哪一种呢?我的原则就是是简单好用,写的代码少,对于一个小白来说,性能、效率什么的,统统被我 pass 了。于是开始接触 urllib、美丽汤(BeautifulSoup),因为听别人说很简单。

我上手的第一个案例是爬取豆瓣的电影,无数人都推荐把豆瓣作为新手上路的实例,因为页面简单且反爬虫不严。照着一些爬取豆瓣电影的入门级例子开始看,从这些例子里面,了解了一点点爬虫的基本原理:下载页面、解析页面、定位并抽取数据。

当然并没有去系统看 urllib 和 BeautifulSoup 了,我需要把眼前实例中的问题解决,比如下载、解析页面,基本都是固定的语句,直接用就行,我就先不去学习原理了。

用 urllib 下载和解析页面的固定句式

当然 BeautifulSoup 中的基本方法是不能忽略的,但也无非是 find、get_text() 之类,信息量很小。就这样,通过别人的思路和自己查找美丽汤的用法,完成了豆瓣电影的基本信息爬取。

用 BeautifulSoup 爬取豆瓣电影详情

更多链接

我们整理了2017年最新政府大数据应用案例!

政府在建设和应用大数据的过程中有独特的优势。政府部门不仅掌握着80%有价值的数据,而且能最大限度调动社会资源,能整合推动大数据发展的各方力量。政府作为大数据建设和应用的主导力量,积极应用大数据决定着能否发挥大数据隐含的战略价值,对行业来说具有引领性作用。以下笔者按部收集了一些大数据的应用案例:

1. 工商部门

重庆依托大数据资源,在全国率先探索建立注册登记监测预警机制,对市场准入中的外地异常投资、行业异常变动、设立异常集中等异常情形进行监控,对风险隐患提前介入、先行处置,有效遏制了虚假注册、非法集资等违法行为。

同时,积极推动法人数据库与地理空间数据库融合运用,建设市场主体分类监管平台,将市场主体精确定位到电子地图的监管网格上,并集成基本信息、监管信息和信用信息。平台根据数据模型,自动评定市场主体的监管等级,提示监管人员采取分类监管措施,有效提升了监管的针对性和科学性。

山西省中小企业产业信息大数据应用服务平台依托大数据、云计算和垂直搜索引擎等技术,为全省中小企业提供产业动态、供需情报、会展情报、行业龙头、投资情报、专利情报、海关情报、招投标情报、行业研报、行业数据等基础性情报信息,还可以根据企业的不同需求提供包括消费者情报、竞争者情报、合作者情报、生产类情报、销售类情报等个性化定制情报,为中小微企业全面提升竞争力提供数据信息支持。

2. 规划部门

重庆市綦江区规划局委托上海复旦规划建筑设计研究院及重庆移动共同开展,利用重庆移动相关数据及綦江相关统计年鉴数据对綦江中心城区人口、住宅、商业、公共服务配套等进行大数据分析,量化綦江房地产库存,从城市建设角度提出改进策略,完善城市功能,促进城市健康发展。

据介绍,经过多次尝试,重庆移动率先将手机信令数据引入城市规划,通过建立人口迁移模型,提供2013-2015年期间綦江区人口的流入流出情况(包括国际、省际、市内流动),建立职住模型提供綦江区居住及工作人口的分布,通过监控道路周边基站人口流动情况,反应綦江区全天24小时道路人口流动情况,识别出各个时段道路堵点。

3. 交通部门

2016年10月,杭州市政府联合阿里云公布了一项计划:为这座城市安装一个人工智能中枢——杭州城市数据大脑。城市大脑的内核将采用阿里云ET人工智能技术,可以对整个城市进行全局实时分析,自动调配公共资源,修正城市运行中的问题,并最终进化成为能够治理城市的超级人工智能。“缓解交通堵塞”是城市大脑的首个尝试,并已在萧山区市心路投入使用,部分路段车辆通行速度提升了11%。

4. 教育部门

徐州市教育局实施“教育大数据分析研究”,旨在应用数据挖掘和学习分析工具,在网络学习和面对面学习融合的混合式学习方式下,实现教育大数据的获取、存储、管理和分析,为教师教学方式构建全新的评价体系,改善教与学的体验。此项工作需要在前期工作的基础上,利用中央电化教育馆掌握的数据资料、指标体系和分析工具进行数据挖掘和分析,构建统一的教学行为数据仓库,对目前的教学行为趋势进行预测,为 “徐州市信息技术支持下的学讲课堂”提供高水平的服务,并能提供随教学改革发展一直跟进、持续更新完善的系统和应用服务。

更多链接

教你训练一个简单的音频识别网络(附代码)

你需要知道,真正的语音与音频识别系统要复杂的多,但就像图像识别领域的MNIST,它将让你对所涉及的技术有个基本了解。

完成本教程后,你将拥有一个模型,能够辨别一个1秒钟的音频片段是否是无声的、无法识别的词语,或者是“yes”、“no”、“up”、“down”、“left”、“right”、 “on”、“off”、“stop”、“go”。你还可以使用这个模型并在Android应用程序中运行它。

注:本文含有大量代码,需要代码原文的同学请参考文末来源地址中的内容。

准备工作

确保你已经安装了TensorFlow,由于脚本程序将下载超过1GB的训练数据,你需要畅通的网络连接,而且你的机器需要有足够的空余空间。训练过程本身可能需要几个小时,所以确保你有一台可以使用这么长时间的机器。

训练

开始训练前,在TensorFlow 源码树下运行:

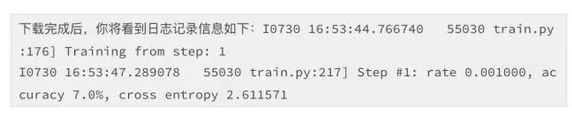

这个脚本程序将开始下载“语音命令数据集”,包括65000条由不同的人说30个不同词语组成的WAVE音频文件。这份数据由Google收集,并在CC-BY协议许可下发行,你可以通过贡献自己五分钟的声音来帮助提升它。这份文件大小超过1GB,所以这部分可能需要一段的时间,但你应该看一下过程日志,一旦它被下载一次,你就不需要再进行这一步了。

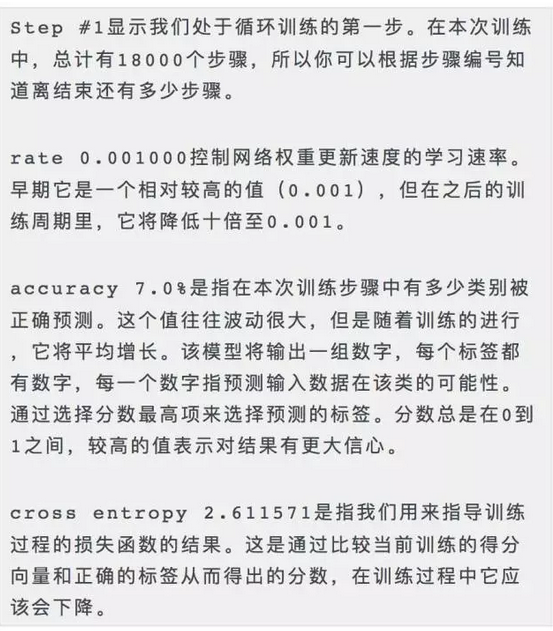

这表明初始化进程已经完成,循环训练已经开始,你将看到每一次训练产生的输出信息。这里分别解释一下含义:

更多链接

|  /2

/2