问题导读:

1.CDH为什么更好? 2.怎样解决低效的MapReduce Job? 3.怎样解决内存溢出?

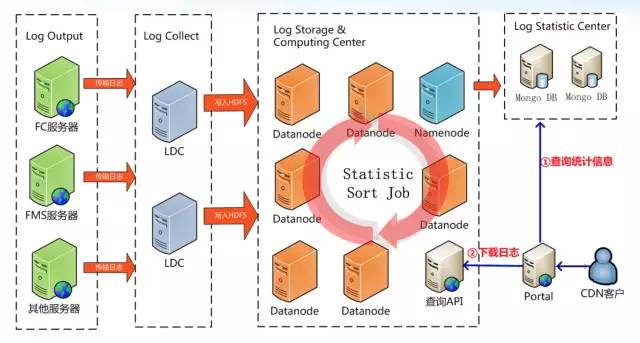

Hadoop在蓝汛

系统架构:

Cloudera和它的产品们

Apache Hadoop与CDH版本关系

CDH为什么更好?

yum ,tar, rpm, cloudera manager 四种安装方法

CDH3u3重大改善

CDH3u4重大改善

Cloudera Manager

Cloudera Training

分为Administrator和Development两门课程

运维事故

1、伤不起的内存

现象1

系统上线第二天,Jobtracker不工作,web页面打不开原因

一次提交Job数量太多,导致Jobtracker 内存溢出解决

调大JT内存;限制Running Job数量

现象2

NN内存溢出,重启后发现50030页面显示fsimage损坏,调查发现SNN fsimage同样损坏了原因

小文件太多导致NN/SNN内存溢出,导致fsimage文件损坏,但是重启后的NN可以正常服务。原因

Cloudera google group去救,获得后门脚本

2、低效的MapReduce Job

现象

MapReduce Job执行时间过长原因

MR中用到了Spring,小文件导致Map方法效率低下,GZ文件读写效率低解决

MR去Spring化;开启JVM重用;使用LZO作为输入和map输出结果;加大reduce并行copy线程数

压缩与MapReduce性能

- 前提:大量小文件

- 输入147GB,文件数45047,平均3MB

- CPU 8 core;32GB内存;7200转磁盘;28台Slave机器

3、OMG,整个集群完蛋了

现象

早上来发现所有DataNode都dead了,重启后10分钟,DN陆续又都dead了;调查发现节点有8%左右丢包率原因

交换机模块故障;DN不能Hold住大量小文件解决

升级3u2到3u4;设置DN内存到2GB遇到无法跨越的问题解决办法

- 加入Hadoop官方Mail List

- 加入Cloudera Google Group

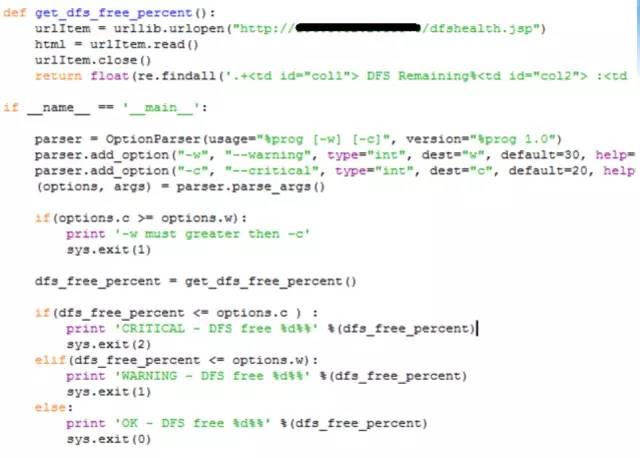

监控与告警

- 监控:ganglia

- 设备告警、服务告警:nagios

- 业务告警:自己实现

Nagios告警:

业务监控:

|  /2

/2