大家已经对hadoop了解很多,并且知道hadoop的内部机制及其mapreduce运行机制。大家也知道如何运行一个mapreduce,如何使用命令将本地文件上传到hadoop hdfs文件系统中,但是大家是否想过如何将实时收集到的实时数据如何push到hadoop hdfs文件系统中,那就需要用facebook开发的scribe动态实时push数据到hdfs文件系统中。下面介绍一下scribe:

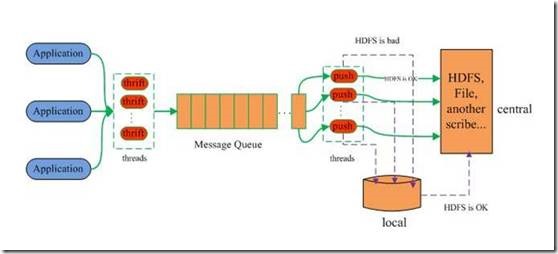

scribe 简介Scribe是Facebook开源的分布式日志收集系统,目前在各大互联网公司内部已经得到大量的应用。它能够从各种日志源上收集日志,存储到一个中央存储系统(可以是NFS,分布式文件系统等)上,以便于进行集中统计分析处理。 它为日志的“分布式收集,统一处理”提供了一个可扩展的,高容错的方案。当中央存储系统的网络或者机器出现故障时,scribe会将日志转存到本地或者另一个位置,当中央存储系统恢复后,scribe会将转存的日志重新传输给中央存储系统。其通常与Hadoop结合使用,scribe用于向HDFS中push日志,而Hadoop通过MapReduce作业进行定期处理。 系统架构:

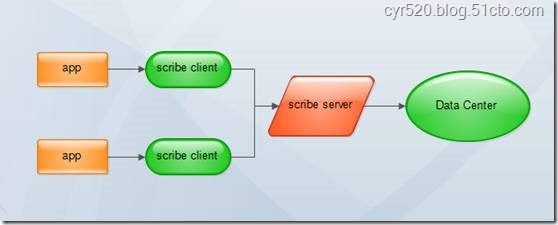

常见部署架构:

|  /2

/2