本帖最后由 sstutu 于 2014-4-28 11:08 编辑

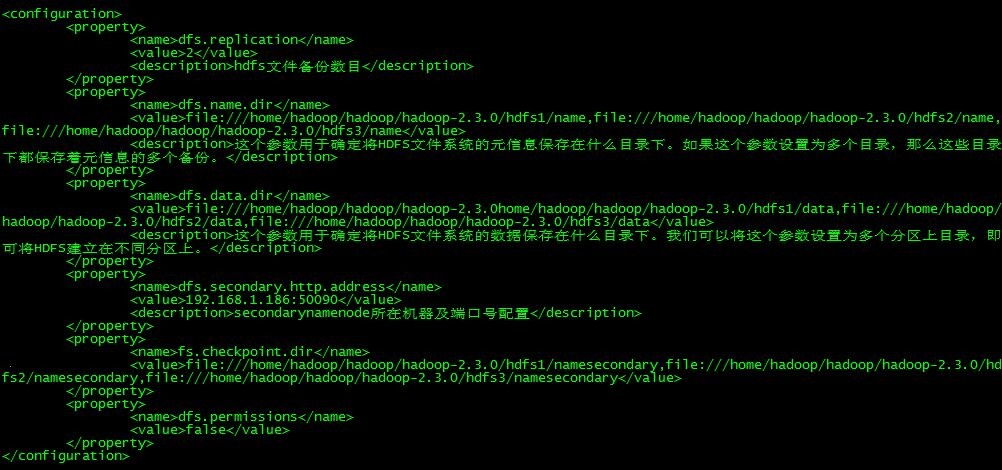

这是hdfs-site.xml文件,麻烦帮我看一下需要配置哪里

core-site.xml

- <property>

- <name>hadoop.tmp.dir</name>

- <value>/home/hadoop/hadoop/hadoop-2.3.0/tmp</value>

- <description>hadoop存放数据的目录,即包括NameNode的数据,也包括DataNode的数据</description>

- </property>

- <property>

- <name>fs.default.name</name>

- <value>hdfs://192.168.1.181:9000</value>

- <description>客户端连接HDFS时,默认的路径前缀</description>

- </property>

- <property>

- <name>mapred.job.tracker</name>

- <value>hdfs://localhost:9001</value>

- </property>

|  /2

/2