|

[mw_shl_code=bash,true]nohup spark-submit --class 'WordCount' --master local[2] --name 'localTest' sparkdemo-1.0-SNAPSHOT.jar > logs/aaa.log &[/mw_shl_code] 本地执行 master为 local 可以获取内容并output

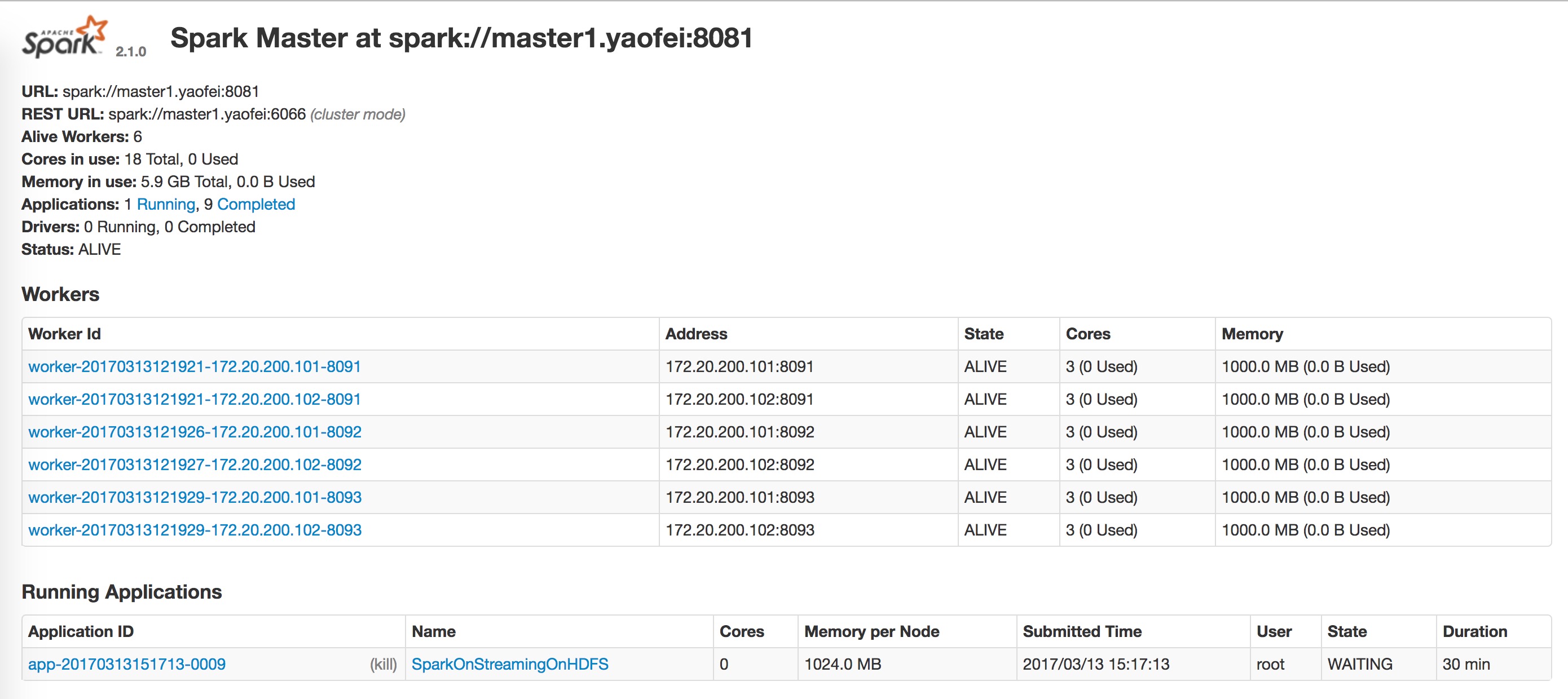

[mw_shl_code=bash,true]nohup spark-submit --class WordCount --master spark://master1.yaofei:8081 --executor-cores 2 sparkdemo-1.0-SNAPSHOT.jar > logs/aaa.log &[/mw_shl_code] 集群环境执行 master 为 spark://master1.yaofei:8081 只能监测到文件新增,但不能获取内容,有个warn:initial job has not accepted any resources; check your cluster UI to ensure that workers are registered and have sufficient resources,有大神知道可能是什么原因吗?或者是我spark-submit 的脚本有什么问题吗?

本地local[2]执行时日志

![本地local[2]执行时日志 本地local[2]执行时日志](data/attachment/forum/201703/13/154524v0ssk55kvnmkxgai.png)

spark集群

|  /2

/2