问题导读:

1.什么是梯度下降法?

2.利用Python如何实验?

3. 如何进行优化?

上一篇:

机器学习教程 六-用scikit-learn求解多项式回归问题

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19073

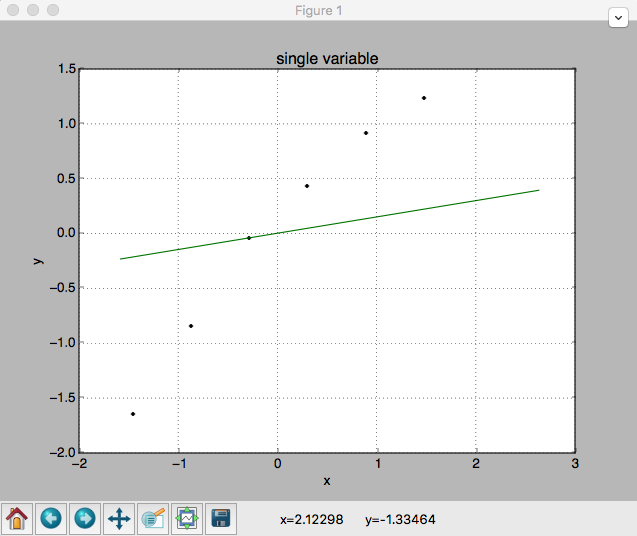

scikit-learn的线性回归模型都是通过最小化成本函数来计算参数的,通过矩阵乘法和求逆运算来计算参数。当变量很多的时候计算量会非常大,因此我们改用梯度下降法,批量梯度下降法每次迭代都用所有样本,快速收敛但性能不高,随机梯度下降法每次用一个样本调整参数,逐渐逼近,效率高,本节我们来利用随机梯度下降法做拟合

梯度下降法

梯度下降就好比从一个凹凸不平的山顶快速下到山脚下,每一步都会根据当前的坡度来找一个能最快下来的方向。随机梯度下降英文是Stochastic gradient descend(SGD),在scikit-learn中叫做SGDRegressor。

样本实验

依然用上一节的房价样本

[mw_shl_code=python,true]X = [[50],[100],[150],[200],[250],[300]]

y = [[150],[200],[250],[280],[310],[330]][/mw_shl_code]

创建sgd_regressor.py,内容如下:

[mw_shl_code=python,true]# coding:utf-8

import sys

reload(sys)

sys.setdefaultencoding( "utf-8" )

import matplotlib.pyplot as plt

from sklearn.linear_model import SGDRegressor

from sklearn.preprocessing import StandardScaler

plt.figure() # 实例化作图变量

plt.title('single variable') # 图像标题

plt.xlabel('x') # x轴文本

plt.ylabel('y') # y轴文本

plt.grid(True) # 是否绘制网格线

X_scaler = StandardScaler()

y_scaler = StandardScaler()

X = [[50],[100],[150],[200],[250],[300]]

y = [[150],[200],[250],[280],[310],[330]]

X = X_scaler.fit_transform(X)

y = y_scaler.fit_transform(y)

X_test = [[40],[400]] # 用来做最终效果测试

X_test = X_scaler.transform(X_test)

plt.plot(X, y, 'k.')

model = SGDRegressor()

model.fit(X, y.ravel())

y_result = model.predict(X_test)

plt.plot(X_test, y_result, 'g-')

plt.show() # 展示图像[/mw_shl_code]

请尊重原创,转载请注明来源网站www.shareditor.com以及原始链接地址

讲解一下

这里需要用StandardScaler来对样本数据做正规化,同时对测试数据也要做正规化

我们发现拟合出的直线和样本之间还是有一定偏差的,这是因为随机梯度是随着样本数量的增加不断逼近最优解的,也就是样本数量越多就越准确

优化效果

既然样本数多拟合的好,那么我们把已有的样本重复多次试一下,修改成如下:

[mw_shl_code=python,true]X = [[50],[100],[150],[200],[250],[300],[50],[100],[150],[200],[250],[300],[50],[100],[150],[200],[250],[300],[50],[100],[150],[200],[250],[300],[50],[100],[150],[200],[250],[300],[50],[100],[150],[200],[250],[300],[50],[100],[150],[200],[250],[300],[50],[100],[150],[200],[250],[300]]

y = [[150],[200],[250],[280],[310],[330],[150],[200],[250],[280],[310],[330],[150],[200],[250],[280],[310],[330],[150],[200],[250],[280],[310],[330],[150],[200],[250],[280],[310],[330],[150],[200],[250],[280],[310],[330],[150],[200],[250],[280],[310],[330],[150],[200],[/mw_shl_code]

最终成像如下:

这回靠谱了许多,实事上,如果再继续重复样本,效果会更逼近

相关文章

机器学习教程 一-不懂这些线性代数知识 别说你是搞机器学习的

http://www.aboutyun.com/forum.php?mod=viewthread&tid=18997

机器学习教程 二-安装octave绘制3D函数图像

http://www.aboutyun.com/thread-19006-1-1.html

机器学习教程 三-用scikit-learn求解一元线性回归问题

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19020

机器学习教程 四-用scikit-learn求解多元线性回归问题

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19042

机器学习教程 五-用matplotlib绘制精美的图表

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19060

机器学习教程 六-用scikit-learn求解多项式回归问题

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19073

机器学习教程 七-用随机梯度下降法(SGD)做线性拟合

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19086

机器学习教程 八-用scikit-learn做特征提取

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19095

机器学习教程 九-二元分类效果的评估方法

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19107

机器学习教程十-用scikit-learn的网格搜索快速找到最优模型参数

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19120

机器学习教程 十一-用scikit-learn做聚类分析大数据

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19129

机器学习教程 十二-神经网络模型的原理 大数据

http://www.aboutyun.com/forum.php?mod=viewthread&tid=19339

请尊重原创,转载请注明来源网站www.shareditor.com以及原始链接地址

|

/2

/2