需要说一下你的具体场景,实现方式很多种。

spark适用于实时计算的,如果简单的去重没有必要使用spark。

简单来说:

一、可以使用数据库去重

1.hive去重,把定义输出结果

- db.auto.sohu.com 2000 1500

2.pig也可以去重,这个简单些,可以了解pig语法

Pig编程指南【完整版】书籍分享

PIG实战

pig系统学习

3.当然hbase也可以去重。

上面建议使用pig,hive也可以,时间长一些。

二、自己编写代码去重

spark

比如你现在想用spark,可以的。

采用循环过滤的方法,最后把结果输出保存。

mapreduce

mapreduce同样也是可以的。当我们运行mapreduce的时候有待输入的文件,经过mapreduce处理之后,会有输出文件,这个输出文件就是你想要的结果。

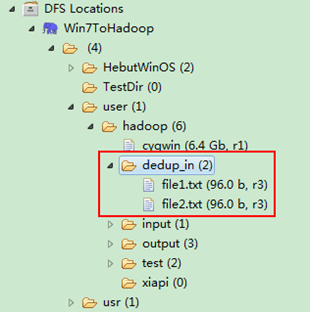

如下输入数据为两个文本文件:

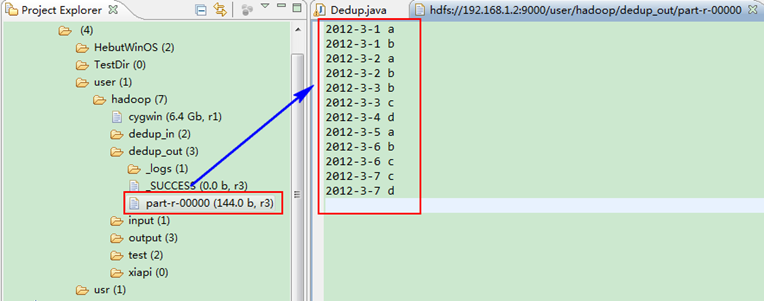

经过mapreduce处理后,如下显示结果

spark也是同样的道理,所以想要得到你想要的结果很容易的。

详细参考

MapReduce初级案例(1):使用MapReduce去重

|  /2

/2